Strana mossa quella di Apple effettuata oggi: attraverso un comunicato stampa ufficiale, ha dettagliato delle feature di accessibilità che arriveranno probabilmente con iOS17. Apple non è solita “spoilerare” ed anticipare funzionalità dei suoi sistemi operativi futuri, ma stavolta evidentemente di carne ce n’era troppa al fuoco, così come accadde l’anno scorso. Vediamo di cosa si tratta.

Le nuove funzionalità sono progettate per facilitare l’uso dei dispositivi Apple a tutti, con particolare attenzione alle persone con disabilità cognitive. Tra queste troviamo Assistive Access, Live Speech e Personal Voice Advance Speech Accessibility, che permettono agli utenti di digitare ciò che vogliono dire. Inoltre, la modalità Point and Speak in Magnifier offrirà agli utenti non vedenti, o a quelli con visione ridotta, la possibilità di indicare e far parlare il proprio smartphone.

Vediamoli più nel dettaglio.

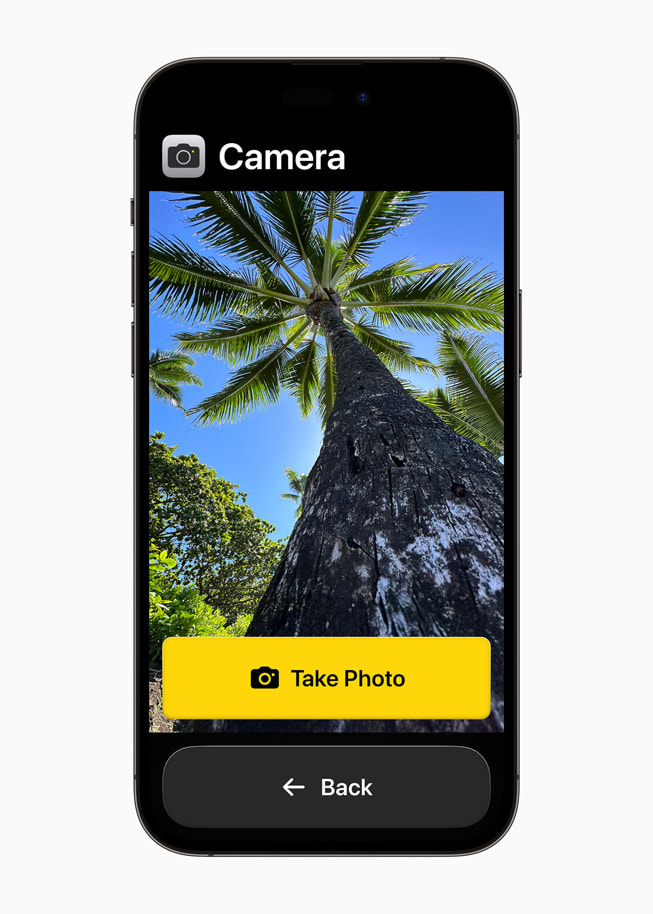

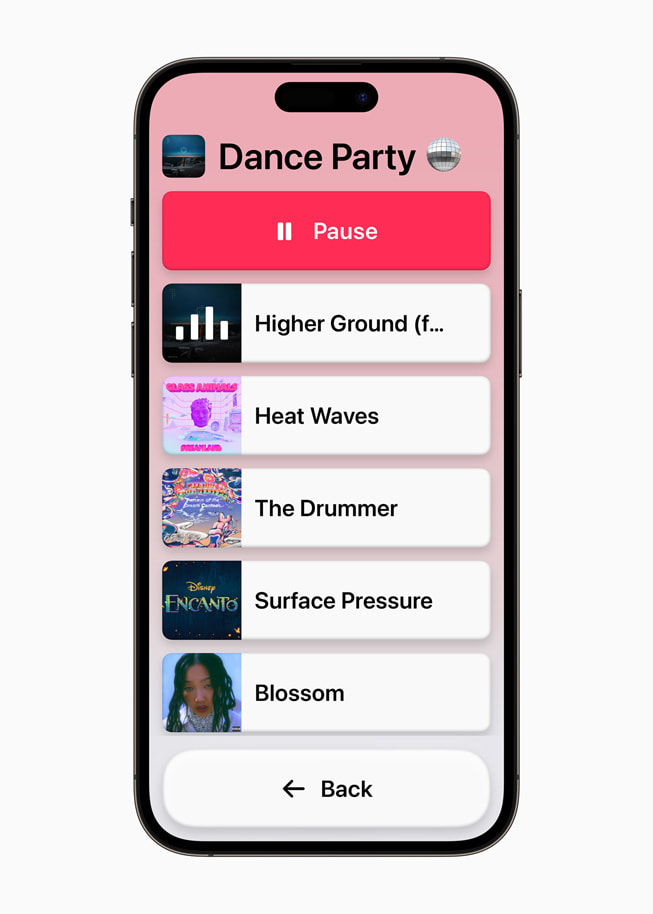

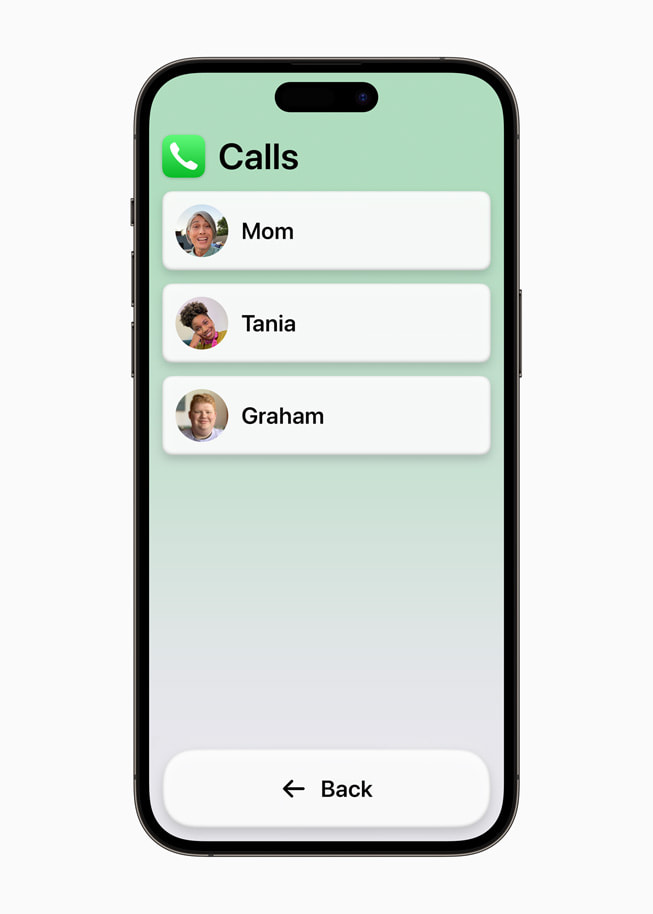

Assistive Access sembra destinato a rivoluzionare l’approccio all’accessibilità. Questa funzionalità “riduce” le app e le esperienze “alle loro funzionalità essenziali per alleggerire il carico cognitivo”. In questo modo, alcune delle funzioni più popolari di iPad e iPhone, come ascoltare musica, connettersi con i propri cari e godere di foto, saranno più accessibili a un numero maggiore di persone.

Assistive Access includerà un’esperienza personalizzata per l’app Phone e FaceTime, ora combinate nell’app chiamate, con un’interfaccia utente semplice e distintiva, pulsanti ad alto contrasto, etichette di testo più grandi e metodi più visivi per utilizzare il dispositivo. Sarà disponibile anche una tastiera solo Emoji.

Live Speech e Personal Voice Advance Speech Accessibility sono state progettate per aiutare milioni di persone in tutto il mondo che non sono in grado di parlare o che hanno perso la capacità di parlare nel tempo. Gli utenti potranno digitare ciò che vogliono dire e il sistema lo riprodurrà con una voce personalizzata, creata dall’utente stesso attraverso un breve setup che dura circa 15 minuti. In questo modo, a quanto si è capito, l’utente potrà interagire con il mondo che lo circonda con la propria voce, anche quando non può fisicamente usarla, temporaneamente o definitivamente. Questa funzione è assolutamente incredibile per quello che promette.

La modalità di rilevamento in Magnifier permetterà alle persone con disabilità visive di capire cosa dice o cosa rappresenta un oggetto. Ad esempio, puntando il dispositivo su un cartello, Magnifier leggerà il testo del cartello.

Nonostante Apple non abbia affermato direttamente che queste funzionalità siano destinate a iOS 17 e iPadOS 17, l’anno scorso si è verificata una situazione simile quando ha presentato nuove funzionalità di accessibilità prima del WWDC 2022. Queste novità renderanno iOS e iPadOS ancora più utili per gli utenti, trasformando gli iPhone e gli iPad in strumenti di accessibilità ancora più efficaci.

Lascia un commento