Dopo l’incredibile conferenza tenuta ieri da OpenAI, che in soli 15 minuti ha stravolto letteralmente l’umanità intera, è giunto il momento per Google di sparare le proprie cartucce, e lo ha fatto per bene durante la sua Google I/O, che però è durata decisamente tanto.

Anzitutto l’evento inizia già ancor prima di iniziare, con delle immagini di attesa ed una scritta che cita testualmente –Questa musica è stata creata utilizzando i nostri modelli di intelligenza artificiale “da immagini a musica”– iniziando subito a stabilire chi è che comanda nel settore delle IA.

Musica maestro!

Dopo le immagini e la musica in questione, c’è stata una sorta di preshow nel quale il DJ e improvvisatore Mark Rebillet, uscendo da una tazza (avete letto bene), ha iniziato a urlare GOOGLE! GOOGLE! Ci ha ricordato molto i tempi di Steve Ballmer in cui gridava DEVELOPERS! DEVELOPERS!

Mark, in un monologo definibile molto… strano, ci spiega che il mondo della musica sta per cambiare, e che tutto sarà fatto da un computer grazie a Google. Non un gran monito viste le polemiche che in questi mesi si stanno sollevando attorno alla capacità dell’IA di sostituire la creatività umana.

Comunque sia, la demo continua con Rebillet che attraverso degli slider software inizia a “comporre” una song mettendo assieme vari strumenti e pattern che il “computer” combina assieme in maniera più o meno armonica.

Comunque sia, il risultato finale non è stato così emozionante, ad voler essere buoni. Comunque sia, se volete fare il Rebillet della situazione, potete andare su Google Labs e divertirvi, facendo magari un lavoro migliore.

Finita la demenziale parentesi musicale (decisamente trascurabile, anche a livello artistico, a dire il vero) è finalmente iniziato l’evento, aperto da un video che fa il sunto di quanto fatto durante l’ultimo danno da Google con il suo Gemini e le funzionalità IA di Android.

Ovviamente (e finalmente) ad aprire realmente le danze arriva Sundar Pichai. Il CEO di Google inizia il suo discorso dicendo che sono 10 anni che investono nell’Intelligenza Artificiale, ma che al momento siamo ancora all’alba di questa nuova tecnologia, che l’azienda ha integrato in tutti i propri servizi, da Gmail a Youtube, passando per Maps.

Gemini

Il CEO di Google inizia con un discorso nel quale ci spiega quanto successo abbia avuto Gemini, con milioni di utenti che lo utilizzano ogni giorno.

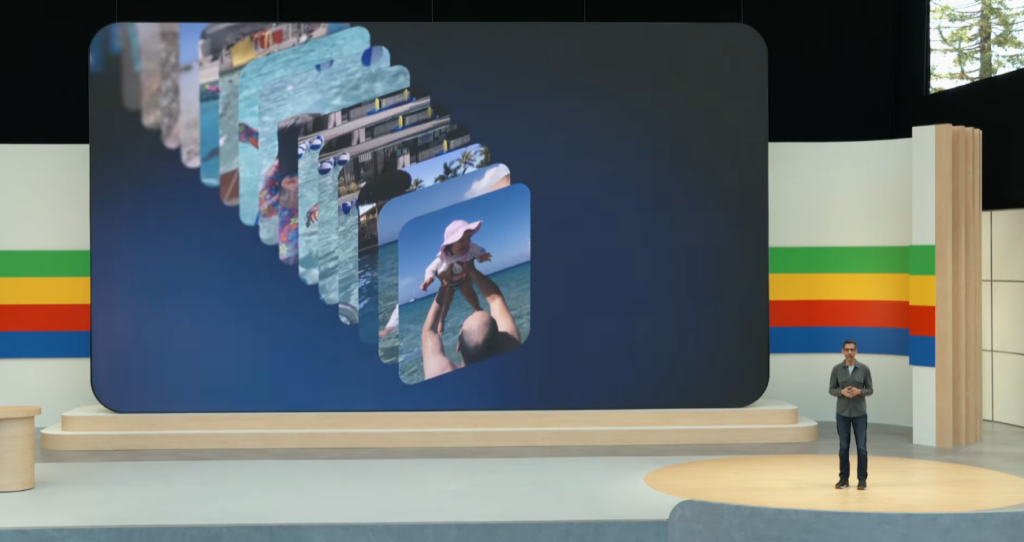

Prosegue poi annunciando delle integrazioni più profonde nelle Google Apps, facendo ad esempio l’esempio di Google Photos, che ora non si limita più ad accettare delle semplici richieste in stile “foto berlino”, ma vere e propri task di ricerca.

Ad esempio, in Photos, è stato chiesto “qual è la targa della mia auto“, oppure “mostrami come mia figlia è migliorata nel nuoto“, con Gemini che, scandagliando tutto l’archivio, mostrava in maniera impressionantemente precisa tutti gli step della bimba da quando ha fatto il primo tuffo fino a quando ha effettivamente imparato a nuotare per bene.

Photos diventerà più intelligente quest’estate, ed Inizia quindi a definirsi cosa intende Google per IA: integrazione nei propri servizi e applicazioni per un utilizzo più naturale ed efficiente.

Gemini 1.5 Pro è la mente che rende tutto ciò possibile, ed è disponibile a livello globale fin da subito.

Si passa poi a Gmail, per il quale è stato mostrato come si potrà ad esempio cercare tutte le email relative alla scuola con un linguaggio più naturale, e meno da motore di ricerca.

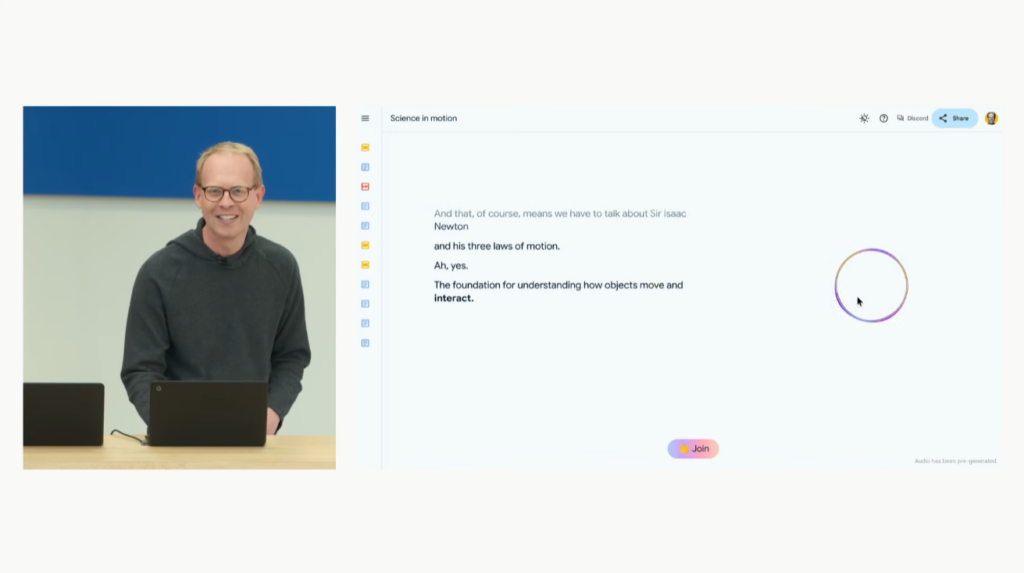

Entra poi sul palco Josh Woodward, che ci mostra NotebookLM, un tool già disponibile da tempo, che aiuta studenti e professori a lavorare insieme. Anche questo strumento è stato potenziato con una funzionalità chiamata “Audio Overview” che ha generato in tempo reale una discussione accademica, nella quale si può anche intervenire facendo domande e cambiando la direzione in cui la discussione sta andando.

Viene posto l’accento su quanto Gemini sia personalizzabile a misura di utente, con le informazioni che gli vengono fornite in pasto.

Torna poi Sundar Pichai che ci mostra come Google Gemini possa integrarsi nella vita quotidiana, ad esempio nello shopping, oppure automatizzando alcuni task che normalmente sarebbero stati da fare manualmente, il tutto per un fine ultimo: rendere l’IA utile per tutti.

Arriva poi sul palco Demis Hassabis, neuroscenziato e cofondatore di DeepMind, divisione che si preoccupa di applicare l’IA a ricerca e sviluppo, con impegni come scoprire nuovi materiali o trasformare input visivi e di linguaggio, in azioni per robot.

Demis ha proseguito con il presentare Gemini 1.5 Flash, una versione più leggera e meno costosa in termini di risorse della versione Pro, e Project Astra, un sistema che permette alla risposta dell’IA di avere meno latenza, essere molto più veloce e quindi rendere l’interazione più naturale.

Project Astra è letteralmente quanto presentato ieri da OpenAI, con una demo che ha mostrato interazioni in tempo reale da un feed video, con l’utente che chiedeva live informazioni all’IA, che rispondeva in accordo con quello che le veniva mostrato.

La demo poi prosegue passando da un Pixel ad una sorta di (nuovi?) Google Glasses, rendendo il tutto ancora più incredibile. Vi lasciamo al video perché spiegarlo a parole è letteralmente impossibile.

Doug Eck prende poi i riflettori e passa a parlare di Generative AI, e dei progressi che Google ha fatto in questo settore.

Si parte da Imagen 3, ora in grado di creare immagini ancora più realistiche, testi compresi.

Si passa poi alla generazione della musica con la presentazione di Music AI Sandbox, che permette agli artisti di utilizzare l’IA per creare pattern, strofe, o intere canzoni. Purtroppo in questa sezione è tornato in video anche Mark Rebillet ma sorvoliamo.

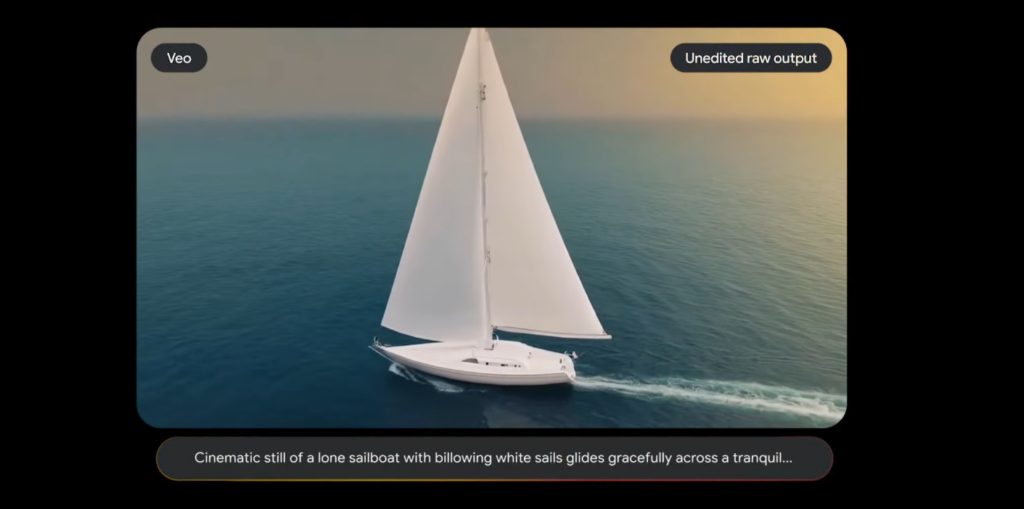

L’ultima area che è stata toccata sono stati i video.

Come con il generatore di immagini, con VEO si possono letteralmente generare dei video in FULLHD partendo da degli input testuali. Gli esempi mostrati sono stati incredibili.

Ribadiamo, incredibili.

Torna sul palco Sundar Pichai, che si fregia di quanto Google abbia investito sulle infrastrutture che permetteranno di usufruire di questi servizi, che richiedono una potenza di calcolo inimmaginabile, annunciando anche nuove soluzioni per le aziende che utilizzano i loro servizi Cloud.

Si passa poi a parlare di ricerca, con Gemini che entra di prepotenza anche nel classico motore di Google, dando risultati molto più precisi, generando risposte più umanizzate, prevedendo cosa vi serve e facendo “il lavoro per voi” in anticipo.

Potete chiedere ad esempio “trovami il miglior posto per fare Yoga, dicendomi anche i prezzi per lezioni introduttive, il tutto a poca distanza da casa mia” e Gemini metterà tutto insieme in un’unica schermata riepilogativa. A seguire poi sono stati fatti vari esempi, come organizzare un piano culinario di tre giorni, cercare un ristorante con determinate condizioni, ecc. ecc.

Il tutto è gestito dalle AI Overviews, di cui abbiamo parlato prima, che purtroppo per ora saranno disponibili solo negli Stati Uniti, con promessa di espansione entro la fine dell’anno.

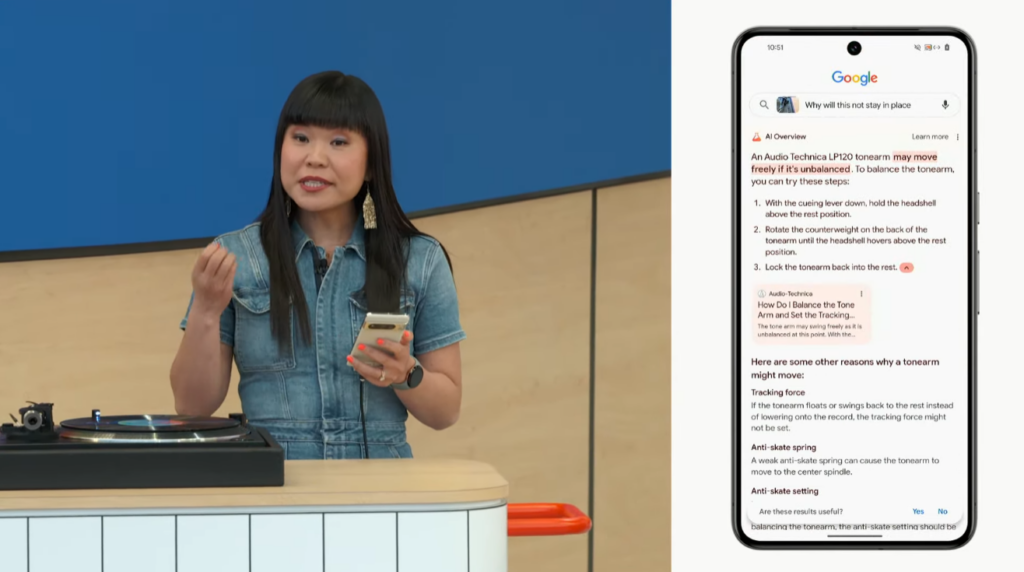

Un’altra dimostrazione molto molto interessante è stata effettuata su Google Lens. Nella demo, viene attivata la fotocamera ed un feed video, e viene chiesto all’IA il perché il giradischi non funziona. Lens riconosce in un attimo sia il modello, sia il problema, e fornice una soluzione.

Tutto questo sarebbe stato possibile solo facendo multiple ricerche. Impressionante davvero.

Tutto questo ben di dio è in arrivo quest’anno, speriamo anche da noi, il prima possibile.

Arriva poi Aparna Pappu sul palco che ci mostra le novità in arrivo su Gmail Mobile, che permetterà di fare sommari dei thread nelle email, scrivere risposte con l’aiuto della IA, o fare una ricerca direttamente in app.

Si passa poi all’interazione tra le varie applicazioni in Workspace, con Gemini che partendo da una semplice email, prende appuntamenti, li segna sul calendario, organizza documenti su drive ed aiuta in generale a tenere traccia di impegni, task, e lavori, il tutto automaticamente e senza soluzione di continuità.

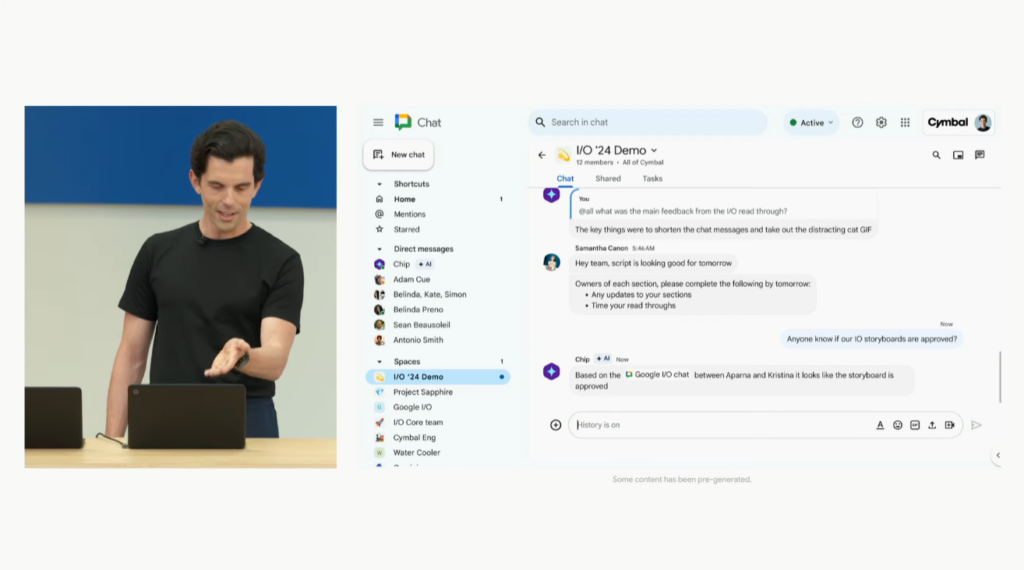

Google è anche a lavoro per il 2025 su un AI Teammate, una sorta di AI bot che però fa parte del team di lavoro e che, una volta configurati quali accessi può avere, partecipa alle chat e può dare risposte immediate prima ancora che i vostri colleghi leggano la vostra richiesta.

Si passa a Sissie Hsiao, che ci parla dell’app Gemini.

L’applicazione ovviamente dà accesso alle ultime novità di Gemini, ed è stata mostrata una nuova versione dell’app con alcune delle funzionalità avanzate di cui abbiamo parlato in questo articolo, con molte altre in arrivo man mano che verranno rilasciate.

Una delle funzioni più interessante mostrate sono le “Gems“, letteralmente delle identità che possiamo creare e dare a Gemini per agire in base alle nostre istruzioni.

A differenza degli altri chatbot che ad esempio per pianificare una vacanza può dare degli spunti o delle idee generali, Gemini può ad esempio cercare sul web e programmare ogni singolo aspetto della stessa, dal volo, al taxi, all’albergo, ecc. ecc.

Si conclude con delle novità per Gemini Advanced, il servizio a pagamento che è stato ampliato sia nei token disponibili, sia nelle potenzialità. Si potranno ad esempio caricare più file pdf, video lunghi fino ad un’ora, 30.000 righe di codice, per essere analizzati e per avere consigli o pareri su qualsiasi cosa li riguardino.

Le nuove funzioni di Gemini Advanced saranno disponibili da oggi in 35 lingue aggiuntive, oltre ovviamente all’inglese.

Android

Anche Android ha avuto il suo spazio, con tre punti focali:

AI Powered Search:

Si inizia con il Circle to Search, funzionalità che abbiamo già visto sui Samsung Galaxy S24, parlando della sua integrazione profonda in Android.

Il Circle to Search potrà essere utilizzato anche non solo per cercare un qualcosa a schermo, ma anche per, ad esempio, risolvere problemi matematici.

Gemini Assistant:

Google Assistant verrà mandato in pensione, ed in sua sostituzione arriverà Gemini Assistant, che potrà essere richiamato così come si richiamava il vecchio assistente, ma sarà più utile, avrà percezione del contesto e di quello che c’è a schermo, e soprattutto potrà interagire con le funzioni dello smartphone.

Gemini potrà anche generare immagini, e far accedere a tutte le funzionalità dell’app standalone. Una delle funzionalità più impressionanti che sono state mostrate è stato il fatto di aver fatto delle domande a Gemini durante la riproduzione di un video su YouTube, ed essendo, come detto prima, content aware, potrà rispondere alla domanda relativa a quello che si sta guardando.

Avete un documento PDF di tante pagine aperto? Basterà richiamare l’assistente e fare domande sul file in questione, e dato che Gemini ha accesso allo stesso, potrà leggerlo istantaneamente e rispondere a quanto richiesto.

AI on device:

Con l’ultima versione di Gemini Nano, munito di MultiModality, Google ha annunciato che tra qualche mese molte più operazioni verranno eseguite direttamente on device, riducendo di tantissimo i tempi di risposta ed avendo un occhio di riguardo per la privacy, dato che nessuno dei vostri dati lascerà il vostro dispositivo per essere elaborato da un server.

L’AI on device permetterà anche di avere più sicurezza, anche durante le telefonate: sullo stage è stata eseguita una chiamata demo di una truffa che è stata immediatamente identificata da Gemini, con conseguente avviso all’utente. Il tutto in diretta, ed analizzando la voce nella telefonata. Pazzesco.

Gemini on device insomma riesce a capire il contesto, analizza le voci, guarda le foto, ma lo fa interamente in totale privacy.

Android 15 beta 2

La beta 2 di Android 15 è stata annunciata con supporto a Gemini 1.5, permettendo agli sviluppatori di iniziare a provare quello che sarà il futuro del sistema operativo, dopodiché sono state presentate altre funzionalità dedicate ai developer.

Per chiudere il segmento, Google ha parlato di come si sta impegnando per responsabilizzare l’utilizzo della IA, aggiungendo dei watermark semi invisibili a foto, musica, e presto anche testo e video.

Pixel e Watch

Ci saremmo aspettati uno sneak peek alla nuova linea Pixel 9 e magari ad un bel Watch, ma purtroppo siamo rimasti a bocca asciutta. Sarà per la prossima volta.

Se volete riguardare la conferenza per intero, preparatevi a due ore di AI e cliccate play sul seguente video:

Lascia un commento